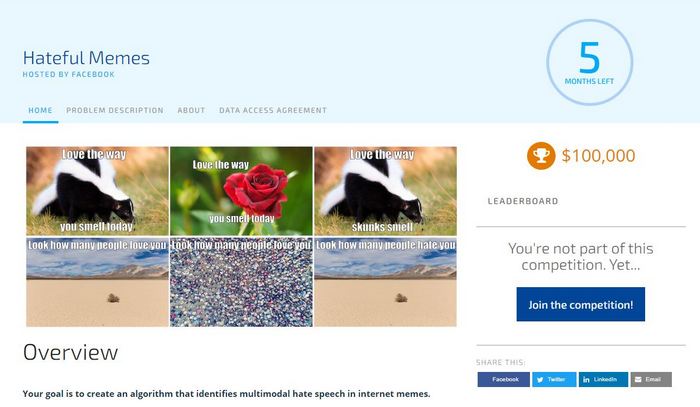

Uno dei fenomeni del web diventati ormai parte della vita quotidiana è di certo dei meme, immagini che possono strappare un sorriso, far sbellicale oppure risultare provocatori, finanche odiosi e discriminatori nei confronti di alcuni. Per quanto riguarda i discorsi di incitamento all’odio, i vari modelli di intelligenza artificiale sono addestrati ad individuare questa tipologia, risultando efficaci in molteplici contesti. Tuttavia l’AI non è ancora in grado di individuare i meme peggiori ed è per questo motivo che Facebook è scesa in campo con un premio da 100.000$!

Facebook, 100.000$ per realizzare un’AI contro i meme di cattivo gusto

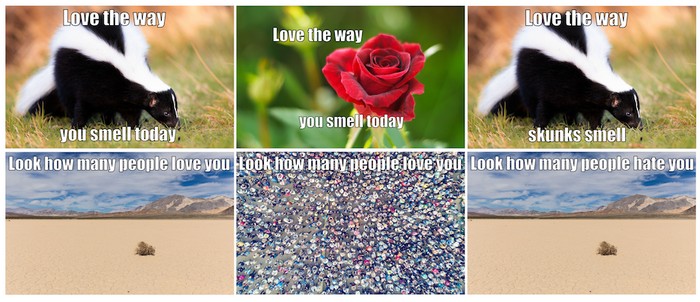

La sfida lanciata dal colosso social mette in palio una cifra davvero niente male per gli sviluppatori interessati ad accoglierla. Facebook offrirà ai developer un set di dati di circa 10.000 immagini su licenza Getty Images, con tanto di contenuto semantico “odioso”. Cioè fungerà da base per creare un modello AI in grado di rilevare meme che incitano all’odio. Secondo quanto rivelato dalla stessa compagnia statunitense, il set di meme fornito comprende tutta usa serie di contenuti di natura sensibile, di solito riportati sui vari social.

Il pacchetto comprende attacchi diretti e indiretti a persone basato su caratteristiche come etnia, razza, nazionalità, immigrazione, religione, sesso, identità di genere, orientamento sessuale, disabilità, malattia. Insomma, si tratta di tutti i contenuti “a rischio”, in grado di incitare all’odio.

Oggigiorno, individuare i discorsi d’odio all’interno dei canali social è diventato un problema vitale per le principali piattaforme, il quale richiede un buona dose di sforzo da parte della stessa intelligenza artificiale utilizzata. Infatti, l’AI deve confrontarsi con un mondo complesso, dov’è anche necessario comprendere il contesto di un meme pubblicato in rete. Una soluzione unica per tutti è impensabile, anche per la stessa celerità con cui cambiano le modalità degli stessi meme.

Per maggiori informazioni sull’iniziativa lanciata da Facebook vi rimandiamo alla pagina dedicata (la trovate qui) con tutti i dettagli del caso.

[su_google]